OVHのケーススタディ:DDoS対策ソリューション

BittWare OVHcloudのお客様は、FPGA技術、特にXUP-P3Rカードを使用して、強力なアンチDDoSソリューションを構築しました。

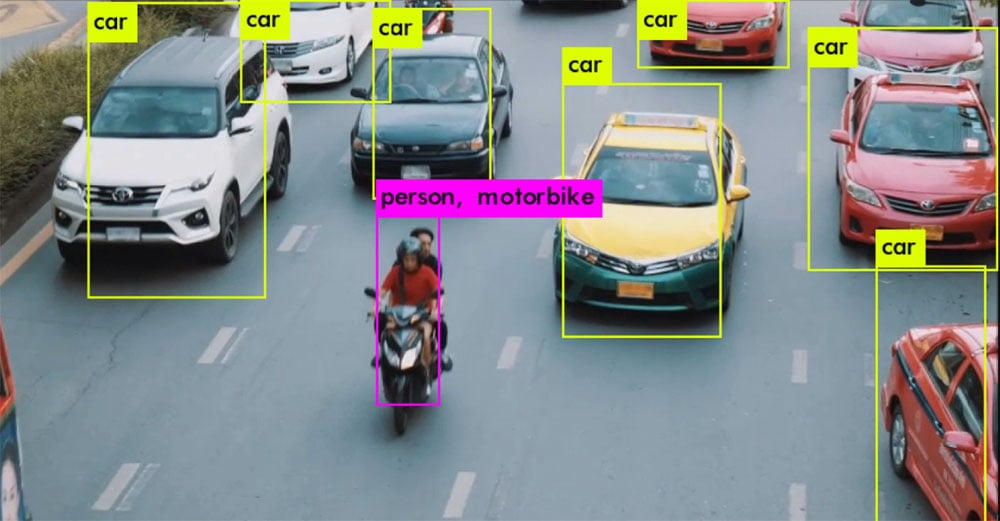

AI/MLモデルと推論では、数年で多くのことが変化しています。学習アルゴリズムの処理に優れたハードウェアは、リアルタイムでバッチサイズ1の推論を行う際のレイテンシーや利用率で遅れをとることがあります。ディープラーニングモデルはより複雑になり、リアルタイムアプリケーションに対応するための新しいアプローチが必要になっています。

機械学習が成熟するにつれて、アクセラレーション の技術はより賢く、より効率的になっています。これは、専用のASICデバイスを使用するなどのシリコンレベルでも、接続に8ビット整数を使用するなどの設計アプローチでも同じです。

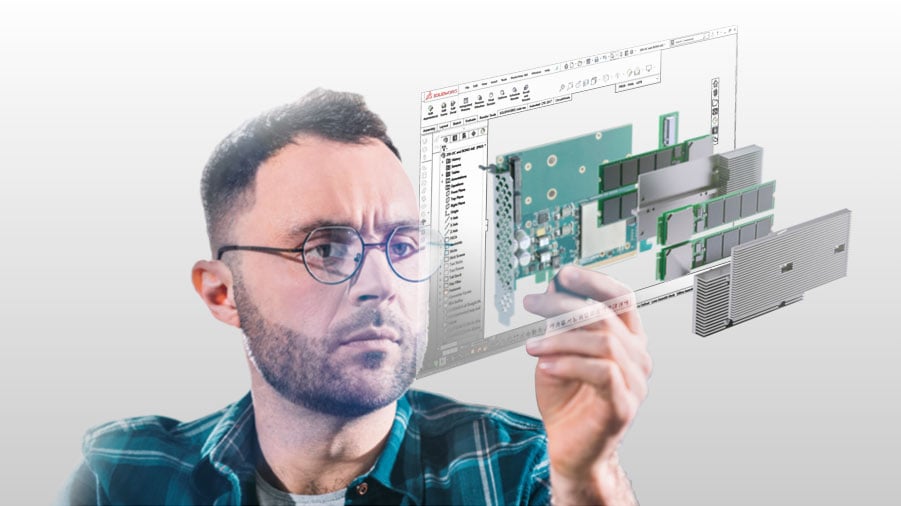

BittWare30年以上にわたって最高のアクセラレーション テクノロジーを市場に送り出してきた信頼あるブランドであり、推論に最適化されたFPGAおよびASICベースのAIソリューションのエコシステムを構築しています。

CPUやGPUベースのシステムを最新のデータセンター・グレードのテンソル・プロセッサーに拡張する場合でも、エッジに特化したソリューションで最後の1ワットまで性能を引き出す場合でも、リスクを低減してより早く市場に投入するために必要なものを用意しています。

BittWare AI/MLのお客様はどこに展開しているのでしょうか?

また、一部のパートナーには、その技術を評価するための開発プラットフォームも提供しています。

パートナープログラムのエコシステムには、次世代ASICベースのカードからFPGA上で開発するIPまで、さまざまなAI/ML推論オプションが含まれています。

FPGAデバイス上でのニューラルネットワークの推論について、その長所と短所を説明しながら見ていきます。

プログラミングStratix 10 機械学習のためのOpenCLを使用します。カバーするトピックOpenCL、機械学習、Stratix 10。

FPGAの可変精度を利用して、より良い機械学習推論ネットワークを構築する。トピックカバー:機械学習、アプリケーションテーラリング、Arria 10.

BittWare OVHcloudのお客様は、FPGA技術、特にXUP-P3Rカードを使用して、強力なアンチDDoSソリューションを構築しました。

記事 カスタマイズされた FPGA ソリューションを迅速に開発するための 2 つのアプローチBittWare カスタマイズされたソリューションのライフサイクル全体にわたってリスクを低減する方法 概要 データセンターにおける FPGA は、FPGA を使用しています。

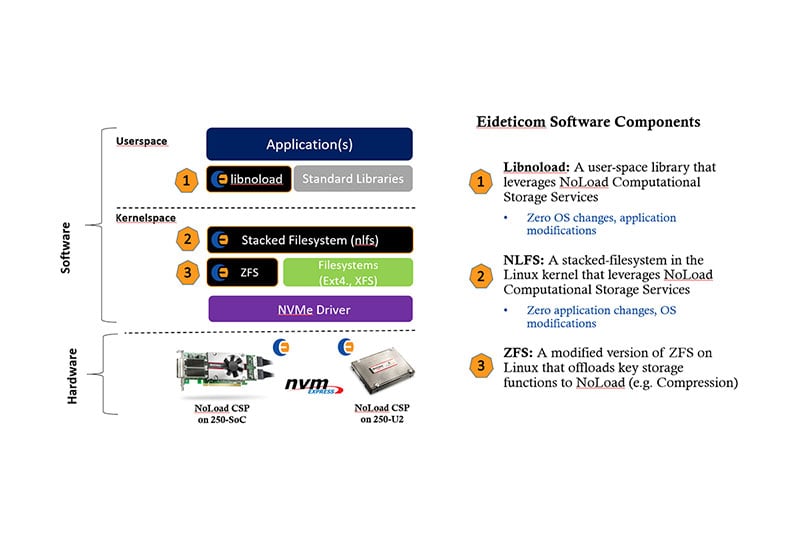

BittWare オンデマンドウェビナー Computational Storage:アクセラレーション をデータに近づける 高性能ストレージは、アクセラレーション がストレージに近づき、従来のフォームファクターが変わるにつれて変化しています。

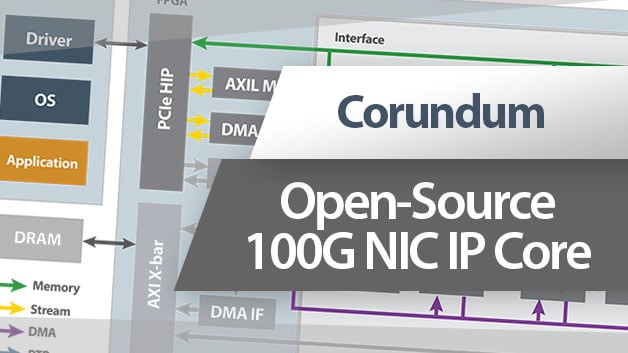

IP&ソリューションに戻る Corundumオープンソース100G NIC IPコア オープンソースのCorundum IPコアで、SmartNICプロジェクトをジャンプスタートさせましょう!このコアは、以下の機能を備えています。