加快边缘的人工智能推理

以更低的延迟和更高的功率效率运行您今天运行的相同模型和工作负载

什么是MERA、DNA和SAKURA-I?

MERA编译器框架:

- MERA编译器和软件框架是一个不折不扣的超低延迟解决方案,它可以在SAKURA- I和FPGA支持的异构系统中优化工作负载。

- 利用MERA,意味着你很可能不需要重新训练你的模型来利用DNA IP加速的优势。

动态神经加速器(DNA):

神经处理引擎IP

- 通过获得专利的 "可重构数据路径技术 "实现近乎最佳的计算利用率,使人工智能处理器的计算元素在低批处理规模下得到最高的利用。

- 与MERA编译器框架相结合,在任何硬件平台(SAKURA-I或FPGA)上都能以较低的功率提供高吞吐量和低延时。

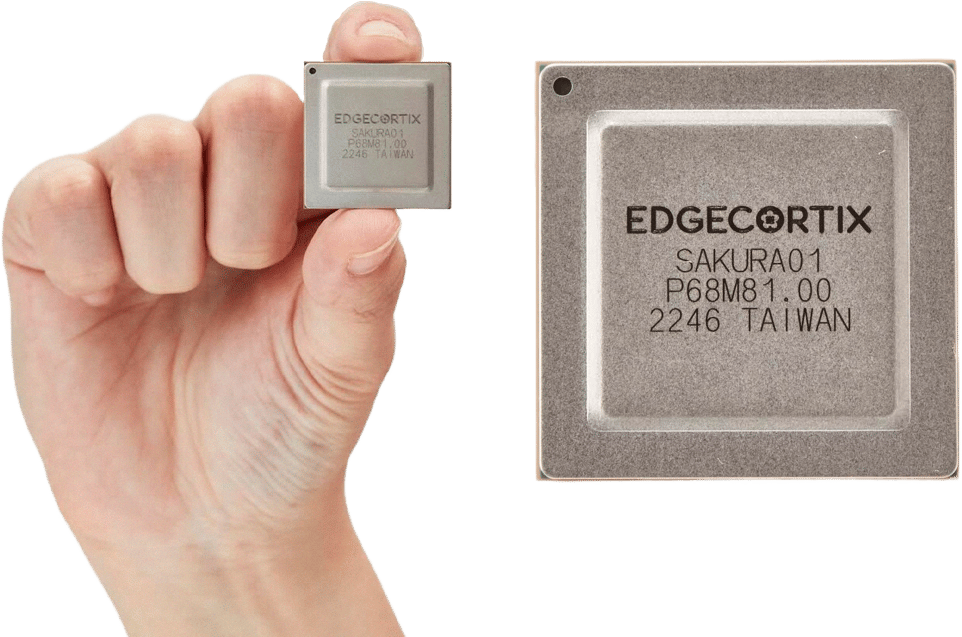

SAKURA-I

- 一个革命性的新的、40 TOPS、10W TDP的人工智能协处理器芯片,专门设计用于实现比领先的GPU更好的能源效率的数量级。

- SAKURA是为运行DNA架构而设计和优化的硬件,使其能够以超低的延迟一起运行多个深度神经网络模型,同时保持卓越的TOPS利用率。

视频

使用EdgeCortix SAKURA-I的超快速Yolov5物体检测

选择正确的解决方案

想加速你的边缘人工智能工作负载?有许多选择可以开始,无论你是处于早期开发阶段,还是准备在一个复杂的模块上进行批量生产。

SAKURA-I ASIC开发套件

将 SAKURA-I 芯片安装在小尺寸 PCIe 卡上,非常适合台式机开发。包括 MERA 编译器框架和工具,以及嵌入到 SAKURA-I 中的 DNA 神经处理引擎。

FPGA加速器卡

包括MERA编译器框架和工具,DNA神经处理引擎IP,与BittWare的PCIe加速器卡捆绑在一起,采用英特尔Agilex 7 FPGA。点此了解该解决方案的更多细节。

定制卡或微电子模块

有了高能效的ASIC,定制的卡或微电子模块就能完美地融入其中。

概述:EdgeCortix SAKURA-I,同类中最节能的边缘AI协处理器

EdgeCortix SAKURA-I是一款TSMC 12纳米FinFET协处理器(加速器),为边缘人工智能(AI)推理提供一流的计算效率和延迟。 边缘人工智能(AI)推理提供一流的计算效率和延时。它由每秒40万亿次的运算(TOPS)驱动、 单核 动态神经加速器 (DNA)知识产权(IP)。它是EdgeCortix专有的神经处理引擎,具有内置的运行时重新配置功能。 它是EdgeCortix专有的神经处理引擎,内置运行时可重新配置的数据路径,将所有计算引擎连接在一起。DNA 使得新的SAKURA-I人工智能协处理器能够以超低的延迟同时运行多个深度神经网络模型。 延迟,同时保持卓越的TOPS利用率。这一独特的属性是提高处理速度的关键、 这一独特的属性是提高处理速度、能源效率和片上系统寿命的关键,提供了卓越的总体拥有成本优势。DNA IP专门针对流媒体和高分辨率数据的推理进行了优化。

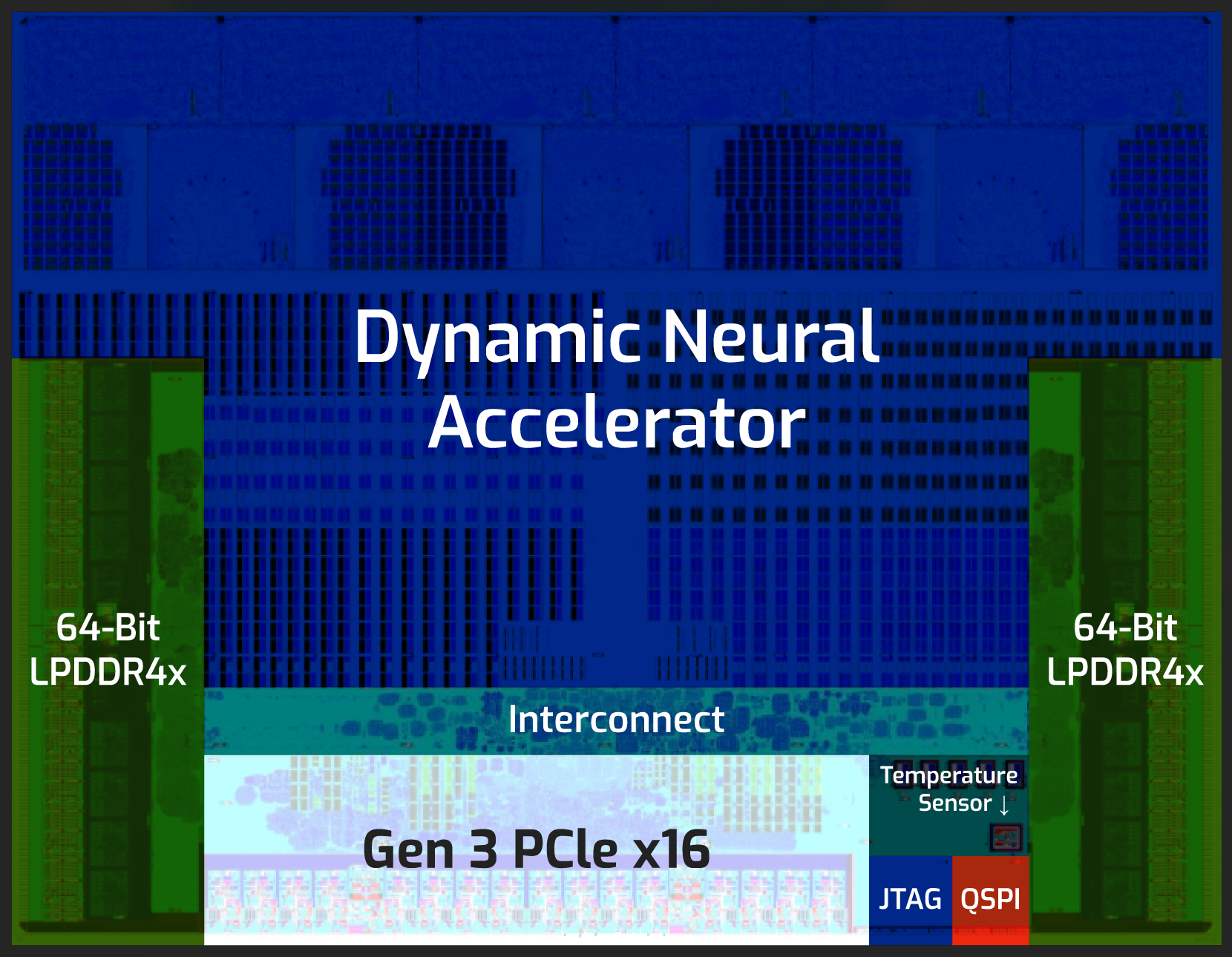

硬件架构概述

- 高达40 TOPS(单芯片)和200 TOPS(多芯片)。

- PCIe设备TDP @ 10W-15W

- 典型型号 功率消耗~5W

- 2×64 LPDDR4x - 16 GB

- PCIe第3代高达16GB/s的带宽

- 两种形式的因素--双M.2和低调的PCIe

- 运行时可重新配置的数据通路

行业

汽车

国防与安全

机器人和无人机

智慧城市

智能制造

EdgeCortix MERA编译器和软件

支持EdgeCortix SAKURA-I人工智能协处理器的设备得到了异构编译器和软件框架--EdgeCortix MERA的支持,该框架可从公共管道库中安装,能够无缝编译和执行在行业标准框架中开发的标准或定制卷积神经网络(CNN)。MERA内置了与Apache TVM的集成,并提供了简单的API,可以无缝地使用SAKURA-I中的DNA AI引擎实现深度神经网络图的编译和推理。它提供了剖析工具、代码生成器和运行时间,在简单的校准和量化步骤后部署任何预训练的深度神经网络。MERA支持模型直接在深度学习框架中进行量化,例如Pytorch或TensorflowLite。

SAKURA-I边缘人工智能平台规格和性能指标:

多样化的运营商支持

- 标准卷积和深度卷积

- 步幅和扩张

- 对称/非对称性填充

- 最大集合,平均集合

- ReLU、ReLU6、LeakyReLU、H-Swish和H-Sigmoid

- 升频和降频

- 剩余的连接,分裂等。

直接替代GPU

- Python和C++接口

- 原生支持PyTorch和TensorFlow-lite

- 不需要再培训

- 支持高分辨率输入

INT8位量化

- 训练后的校准和量化

- 支持深度学习框架内置量化器

- 保持高精确度

内置模拟器

- 在没有SAKURA-I设备的情况下进行部署,在x86环境下模拟

推理。 - 在

不同的条件下估计推理的延迟和吞吐量

准备好获取更多信息了吗?

填写表格以获得更多关于EdgeCortix AI加速解决方案的信息。

"*"表示必填项目