解决方案

改造AI/ML推理

利用更聪明的方法进行人工智能加速

推理加速的新浪潮

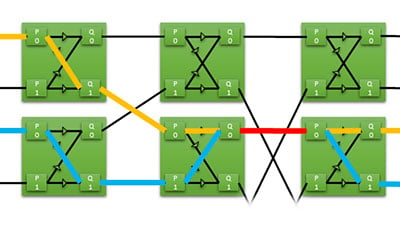

几年来,AI/ML模型和推理发生了很多变化。擅长处理训练算法的硬件在实时、批量1推理的延迟和利用率方面可能落后。深度学习模型已经变得更加复杂,需要新的方法让实时应用跟上。

好消息是,随着机器学习的成熟,加速技术也变得更加智能和 高效。这些都是在硅层面上,如使用专用的ASIC设备,以及在设计方法上,如使用8位整数进行连接。

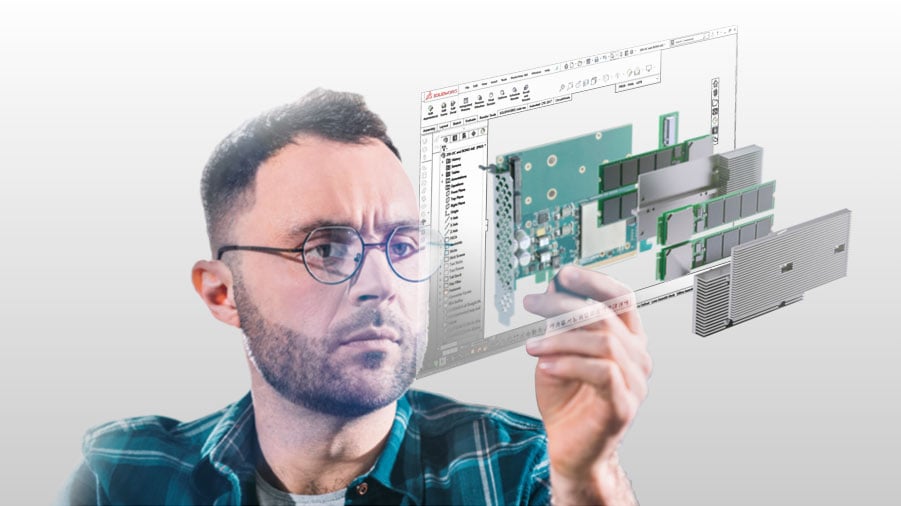

BittWare是一个三十多年来为市场带来最佳加速技术的值得信赖的品牌,它已经组建了一个基于FPGA和ASIC的AI解决方案的生态系统,这些解决方案为推理而优化。

无论是将基于CPU或GPU的系统扩展到最新的数据中心级张量处理器,还是使用以边缘为重点的解决方案获得每一瓦特的性能,我们都能满足你降低风险和更快进入市场的需要。

BittWare + ML/AI推理

何时与BittWare合作

- 你有一个训练有素的模型,你寻求帮助部署它

- 我们可以帮助您进行部署概念验证

- 如果PCIe卡不适合你,我们可以讨论定制的东西。

- 我们可以讨论你将真实世界的数据纳入推理模型的选项

部署目标

BittWare的AI/ML客户部署在哪里?

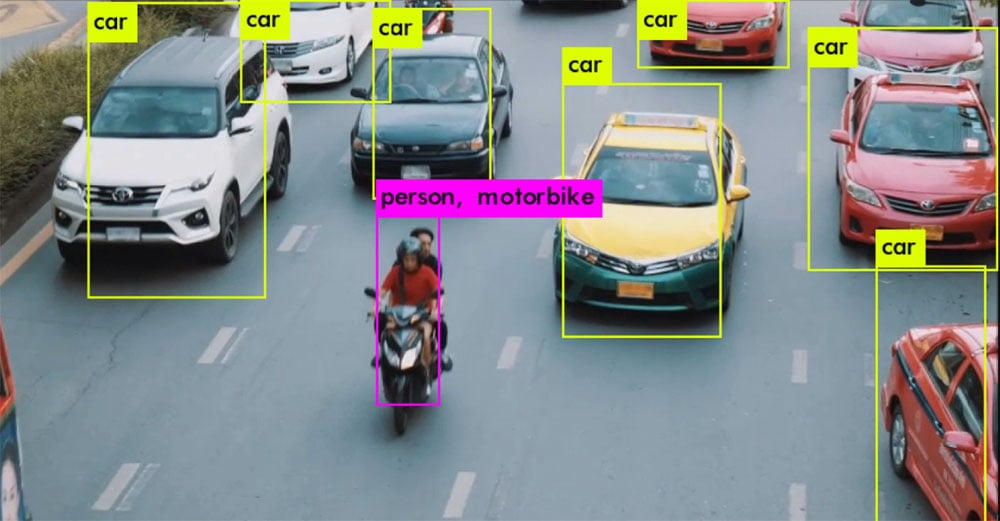

- "边缘部署 "涵盖了从监控摄像头到电线杆再到办公大楼内的壁橱的所有内容。

- 我们可以帮助在数据中心内部署特殊用途的设备(我们的合作伙伴一般都能很好地覆盖数据中心内的传统服务器)。

开发平台

对于一些合作伙伴,我们还提供了用于评估其技术的开发平台。